Dank OpenAI war es eine sehr arbeitsreiche Woche für KI-Nachrichten, darunter ein kontroverser Blogbeitrag von CEO Sam Altman, die weit verbreitete Einführung des Advanced Voice Mode, Gerüchte über 5GW-Rechenzentren, große personelle Veränderungen und spannende Umstrukturierungspläne.

Aber der Rest der KI-Welt hält nicht Schritt, macht sein eigenes Ding und produziert von Minute zu Minute neue KI-Modelle und Forschungsergebnisse. Hier ist eine Zusammenfassung einiger anderer bemerkenswerter KI-Neuigkeiten der letzten Woche.

Google Gemini-Updates

Google am Dienstag Anmelden Aktualisierungen der Gemini-Modellreihe, einschließlich der Veröffentlichung von zwei neuen produktionsbereiten Modellen, die auf früheren Versionen basieren: Gemini-1.5-Pro-002 und Gemini-1.5-Flash-002. Das Unternehmen berichtete von Verbesserungen der Gesamtqualität, mit bemerkenswerten Zuwächsen in den Bereichen Mathematik, Umgang mit langen Kontexten und Sehaufgaben. Google gibt eine Leistungssteigerung von 7 Prozent an MMLU-Pro Standard und eine 20-prozentige Verbesserung bei mathematikbezogenen Aufgaben. Aber wie Sie wissen, wenn Sie Ars Technica schon länger lesen, sind KI-Standards normalerweise nicht so nützlich, wie wir es uns wünschen.

Zusammen mit den Modellaktualisierungen führte Google erhebliche Preissenkungen für das Gemini 1.5 Pro ein, wodurch die Eingabecodekosten um 64 Prozent und die Ausgabecodekosten um 52 Prozent für Ansprüche unter 128.000 Codes gesenkt wurden. Wie der KI-Forscher Simon Willison sagte männlich In seinem Blog heißt es: „Zum Vergleich: GPT-4o kostet derzeit 5 $/[million tokens] Der Input und Output beträgt 15 $/m und das Claude 3.5 Sonnet kostet 3 $/m Input und 15 $/m Output. Der Gemini 1.5 Pro war bereits das günstigste Frontier-Modell und jetzt ist er noch günstiger.“

Google hat auch die Preisobergrenzen erhöht: Gemini 1.5 Flash unterstützt jetzt 2.000 Anfragen pro Minute und Gemini 1.5 Pro verarbeitet 1.000 Anfragen pro Minute. Google weist darauf hin, dass die neuesten Modelle eine doppelt so hohe Ausgabegeschwindigkeit und eine dreimal geringere Latenz bieten als frühere Versionen. Diese Änderungen machen es für Entwickler möglicherweise einfacher und kostengünstiger, Apps mit Gemini zu erstellen als zuvor.

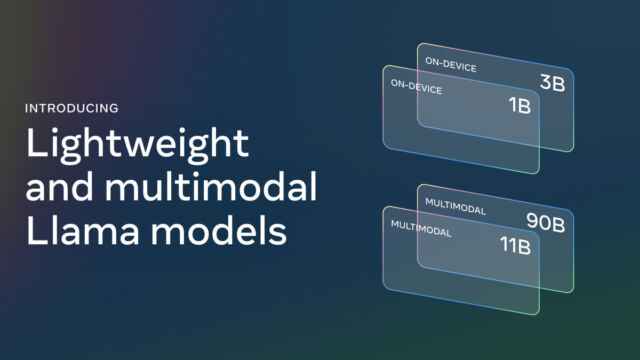

Meta veröffentlicht Llama 3.2

Am Mittwoch war er tot Anmelden Llama 3.2 wird veröffentlicht, ein wichtiges Update der Suite offener KI-Modelle, die wir in der Vergangenheit ausführlich behandelt haben. Die neue Version umfasst visionsfähige Large Language Models (LLMs) mit Parametergrößen von 11B und 90B sowie leichte Nur-Text-Modelle mit 1B- und 3B-Parametern, die für Edge- und Mobilgeräte entwickelt wurden. Meta behauptet, dass die Vision-Modelle mit führenden Closed-Source-Modellen bei Bilderkennungs- und visuellen Verständnisaufgaben konkurrenzfähig sind, während die kleineren Modelle angeblich ähnlich große Konkurrenten bei verschiedenen textbasierten Aufgaben übertreffen.

Willison hat einige der kleineren 3,2f-Modelle getestet Berichtete über beeindruckende Ergebnisse Für Größenmodelle. Ethan Mollick, Forscher für künstliche Intelligenz Zeigen Er ließ Llama 3.2 auf seinem iPhone mit einer App namens PocketPal laufen.

Meta stellte auch den ersten Beamten vor.Lama-StapelDistributionen, die erstellt wurden, um die Entwicklung und Bereitstellung in verschiedenen Umgebungen zu vereinfachen, stellen Meta Vorlagen zum kostenlosen Download bereit, mit Lizenzbeschränkungen. Die neuen Vorlagen unterstützen lange Kontextfenster von bis zu 128.000 Token.

Die AlphaChip AI-Technologie von Google beschleunigt das Chipdesign

Am Donnerstag Google DeepMind Anmelden AlphaChip scheint ein großer Fortschritt im Design KI-basierter Mikrochips zu sein. Ich habe als angefangen Forschungsprojekt Im Jahr 2020 handelt es sich nun um eine verstärkende Lernmethode für die Gestaltung von Folienlayouts. Berichten zufolge hat Google in den letzten drei Generationen AlphaChip zur Erstellung von „Superchip-Layouts“ verwendet Tensorverarbeitungseinheiten (TPUs), das sind Chips, die Grafikprozessoren (GPUs) ähneln und zur Beschleunigung von KI-Vorgängen entwickelt wurden. Google behauptet, dass AlphaChip hochwertige Folienlayouts in Stunden erstellen kann, im Vergleich zu wochen- oder monatelangem menschlichem Aufwand. (Nvidia hat angeblich Auch künstliche Intelligenz wurde eingesetzt Um beim Design ihrer Chips zu helfen.)

Bemerkenswerterweise hat Google auch eine veröffentlicht Vortrainierter Kontrollpunkt Von AlphaChip auf GitHub und teilen Sie die Modellgewichte mit der Öffentlichkeit. Der Einfluss von AlphaChip geht bereits über Google hinaus und es gibt Chip-Design-Unternehmen wie dieses, sagte das Unternehmen mediatek Übernahme und Weiterentwicklung der Technologie für ihre Chips. Laut Google hat AlphaChip eine neue Forschungslinie zur künstlichen Intelligenz für das Chipdesign gestartet, die jede Phase des Chipdesignzyklus von der Computerarchitektur bis zur Fertigung verbessern könnte.

Das ist noch nicht alles, aber hier sind einige der Höhepunkte. Da die KI-Branche derzeit keine Anzeichen einer Verlangsamung zeigt, werden wir sehen, wie sich nächste Woche entwickelt.

„Web-Fan. Neigt zu Apathieanfällen. Bierfanatiker. Möchtegern-Denker.“